Am 12. Februar 2026 veröffentlichte Xiaomi offiziell sein erstes quelloffenes Robotik-VLA-Modell (Vision-Language-Action) mit dem Namen „Xiaomi-Robotics-0“. Mit 4,7 Milliarden Parametern kombiniert dieses Modell visuelles Sprachverständnis mit leistungsstarken Echtzeit-Ausführungsfähigkeiten und stellt in mehreren Benchmarks neue SOTA-Rekorde (State of the Art) auf.

Hier sind die wichtigsten technischen Merkmale und Fähigkeiten des Modells:

Architektur: Zusammenarbeit von Gehirn und Kleinhirn

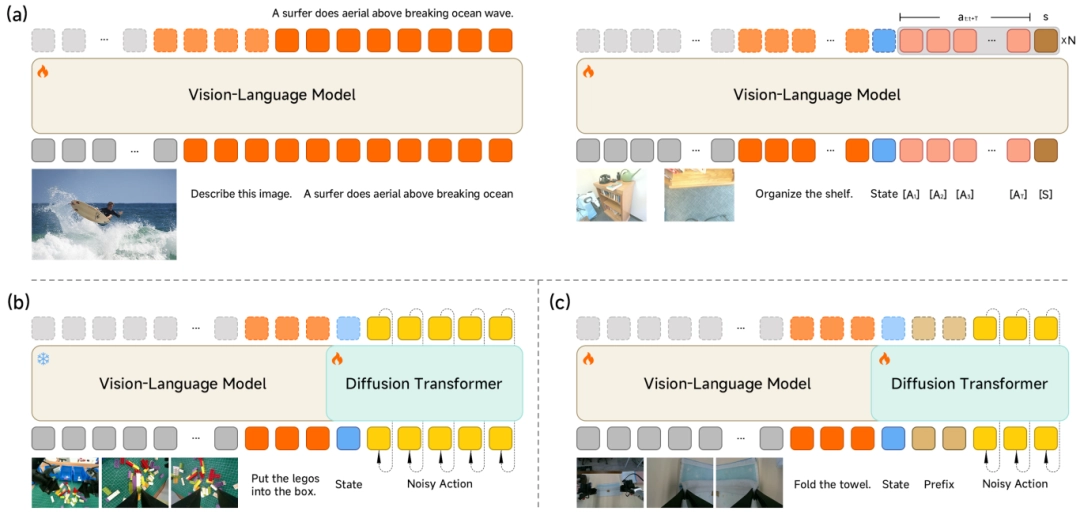

Um die Balance zwischen allgemeinem Verständnis und präziser Steuerung zu halten, verwendet Xiaomi-Robotics-0 eine „Mixture-of-Transformers“- Architektur (MoT ).

-

Visual-Language Brain (VLM): Es basiert auf einer multimodalen VLM-Basis und ist dafür zuständig, vage menschliche Befehle zu verstehen (z. B. „Bitte falten Sie das Handtuch“) und räumliche Beziehungen aus hochauflösenden visuellen Eingaben zu erfassen.

-

Kleinhirn für die Handlungsausführung (Action Expert): Um hochfrequente und gleichmäßige Bewegungen zu erzeugen, wird ein mehrschichtiger Diffusionstransformator (DiT) eingesetzt. Anstatt eine einzelne Aktion auszugeben, erzeugt er einen „Action Chunk“ und sorgt mit der Flow-Matching-Technologie für Präzision.

Ausbildungsstrategie: Verhinderung von „Dumbing Down“

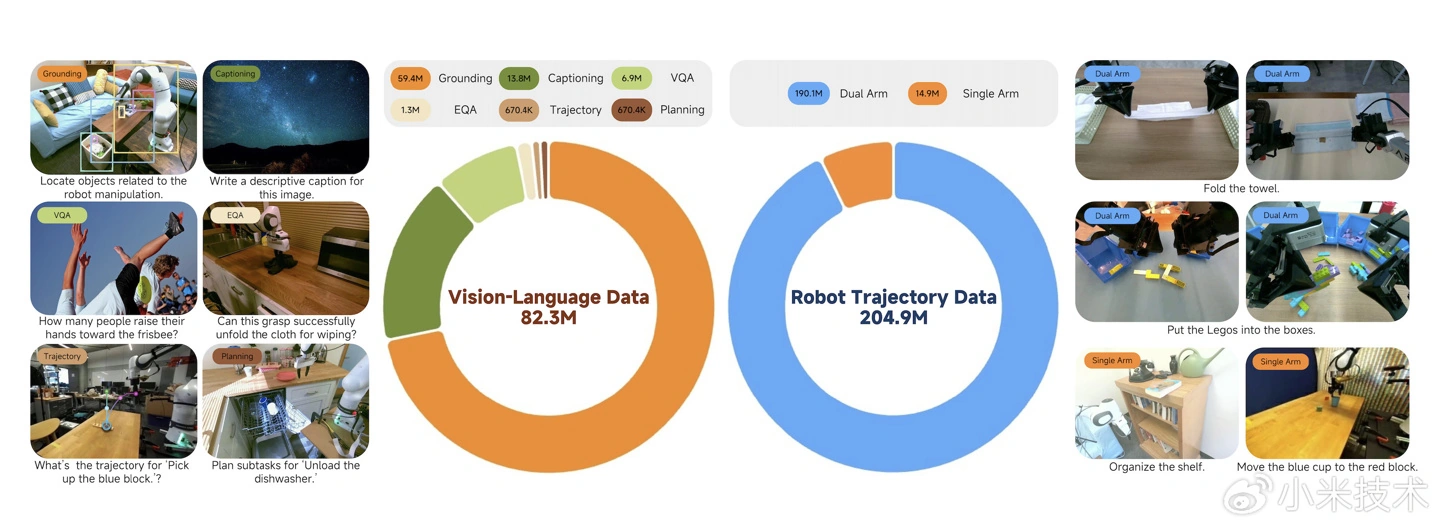

Viele VLA-Modelle neigen dazu, beim Erlernen von Aktionen ihre allgemeinen Verständnisfähigkeiten zu verlieren. Xiaomi begegnet diesem Problem mit einer hybriden Trainingsmethode, die multimodale Daten mit Aktionsdaten kombiniert:

-

VLM Synergistisches Training: Ein „Action Proposal“ -Mechanismus zwingt den VLM, Handlungsverteilungen vorherzusagen, während er Bilder versteht, und gleicht den Merkmalsraum des VLM mit dem Handlungsraum ab.

-

DiT Spezialisiertes Training: Die VLM wird eingefroren und die DiT wird so trainiert, dass sie präzise Aktionssequenzen aus dem Rauschen wiederherstellt und sich dabei ausschließlich auf KV-Merkmale für die Konditionalgenerierung verlässt.

Bewegungen in Echtzeit und im Fluss

Um das „Aktionsstottern“ zu lösen, das durch die Inferenzlatenz bei echten Robotern entsteht, hat das Team innovative Techniken eingeführt:

-

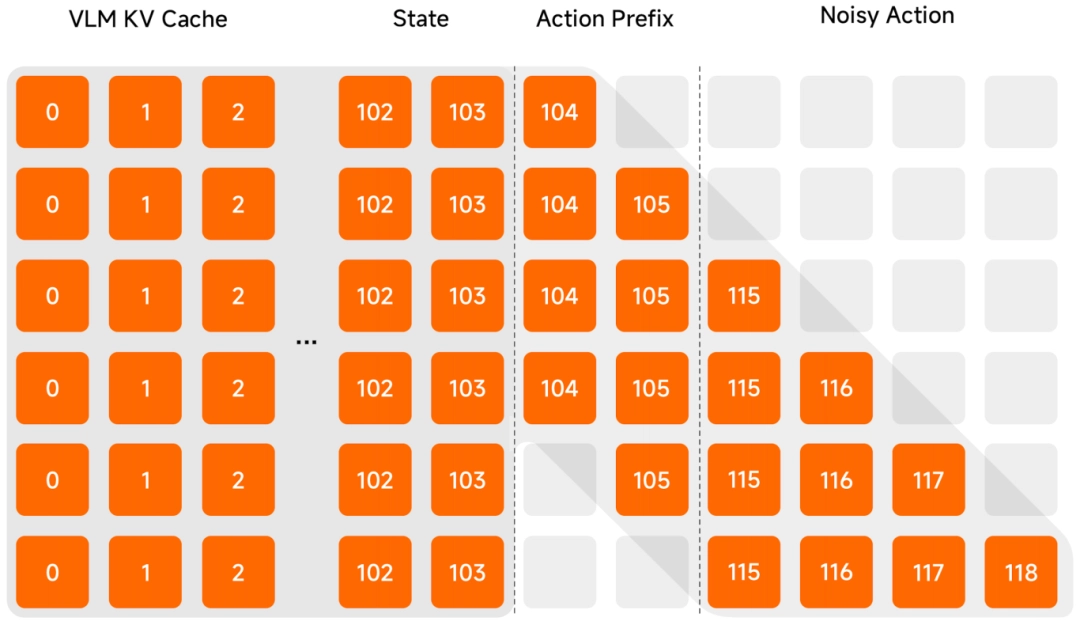

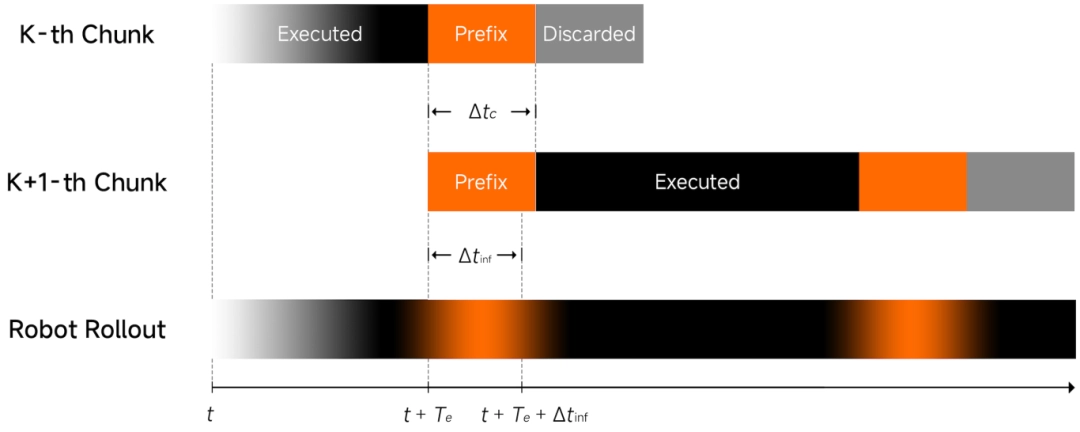

Asynchrone Inferenz: Der Schlussfolgerungsprozess des Modells wird von der Ausführung des Roboters entkoppelt, so dass beide Prozesse asynchron ablaufen können, was einen reibungsloseren Betrieb ermöglicht.

-

Sauberer Aktionspräfix: Verwendet die zuvor vorhergesagte Aktion als Eingabe, um die Kontinuität der Flugbahn zu gewährleisten und Jitter zu reduzieren.

-

$\Lambda$-förmige Aufmerksamkeitsmaske: Eine spezielle Aufmerksamkeitsmaske zwingt das Modell dazu, sich auf das aktuelle visuelle Feedback zu konzentrieren und nicht auf die historische Trägheit, so dass der Roboter sehr schnell auf plötzliche Veränderungen in der Umgebung reagieren kann.

Leistung & Verfügbarkeit

-

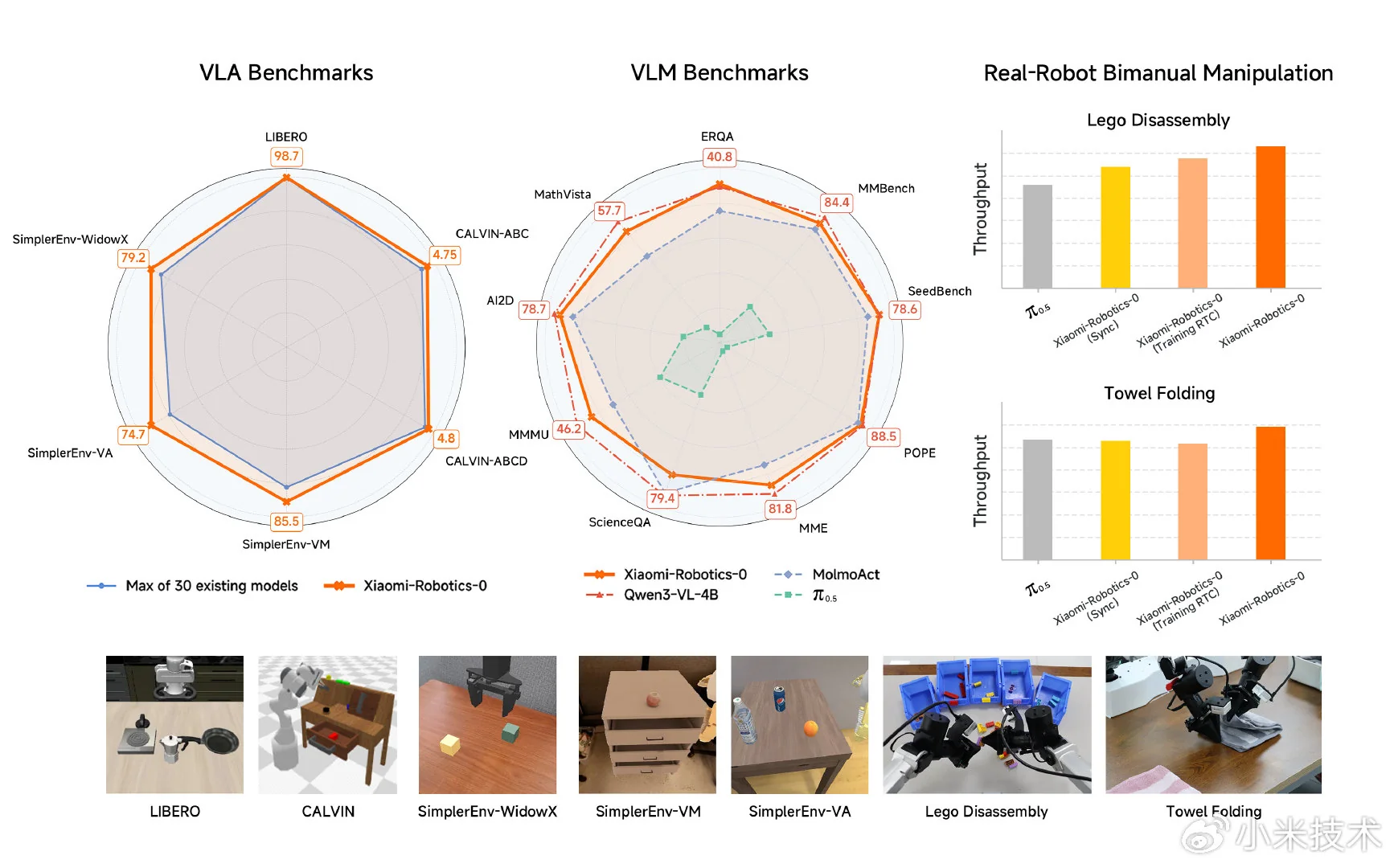

Benchmark-Leader: Das Modell erzielte unter 30 Modellen in Simulationsbenchmarks wie LIBERO, CALVIN und SimplerEnv Spitzenergebnisse.

-

Herausforderungen in der realen Welt: In Tests mit zweiarmigen Robotern zeigte es eine überlegene Hand-Augen-Koordination bei Aufgaben mit langem Zeithorizont wie dem Abbau von Blöcken und dem Falten von Handtüchern.

-

Hardware-Kompatibilität: Es unterstützt Echtzeit-Inferenzen auf Consumer-Grafikkarten.

Xiaomi hat die Projektseite, den Quellcode und die Modellgewichte für die Öffentlichkeit zugänglich gemacht:

- Projektseite: https://xiaomi-robotics-0.github.io

- Code: https://github.com/XiaomiRobotics/Xiaomi-Robotics-0

- Modell Gewichte: https://huggingface.co/XiaomiRobotics

Emir Bardakçı

Emir Bardakçı